背景

VMware Workstation Playerにて仮想マシンを作成しネットワーク設定を行ったが、ゲストOSからインターネットに接続することができない、「サーバーが見つかりません」と表示される。勿論Pingによる疎通確認も不可。

環境

- ホストOS:Windows7 Professional version6.1

- VMware Workstation 15.0.2 Player for Windows 64-bit

- ゲストOS:CentOS7.6

原因

仮想マシンのネットワーク接続をNATに設定し、ホストOSが使用しているWIFIのインターネット共有をVMnet8に対して有効にしていたが、VMwareの設定ファイルに記載されたIPアドレス帯域とVMnet8に自動設定されたものと異なっていた。

※NATとは

ホストのIPアドレスを共有して使用する

解決策

①VMwareの設定ファイルのIPアドレスを確認する。

設定ファイルパス:「C:\ProgramData\VMware\vmnetnat.conf」

#NAT gateway addressのIPアドレスを控える。

②ホストのネットワーク接続からVMnet8のIPアドレスを固定する

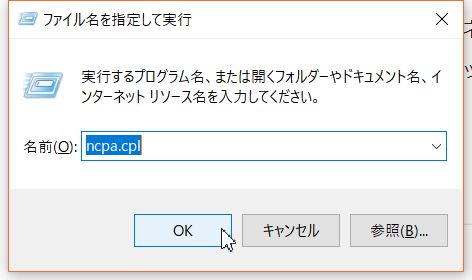

ホストのネットワーク設定は、Windowsキー+Rから「ncpa.cpl」で開くことができる。

vmnetnat.confの#NAT gateway addressに記載されたIPは/24であるため、第4オクテットを任意の数字に固定する。

ゲートウェイは第4オクテット「2」で指定し、DNSはGoogleのパブリックDNSにした。

③仮想マシンのIPアドレスを固定する

仮想マシンの端末を起動し、nmcliコマンドにてIPアドレス、DGW、DNSを指定する。

※上記で固定したIPアドレスとは異なるものにすること。

IPアドレス・サブネット変更

nmcli c modify インターフェース名 ipv4.addresses xxx.xxx.xxx.xxx/24

DGW変更

nmcli c modify インターフェース名 ipv4.gateway xxx.xxx.xxx.xxx

DNS変更

nmcli c modify インターフェース名 ipv4.dns xxx.xxx.xxx.xxx

インターフェースを再起動

nmcli c down インターフェース名; nmcli c up インターフェース名

設定内容を確認

nmcli d show インターフェース名

ネットワーク再起動

systemctl restart network

④Pingで疎通を確認する

どこでもよいが、今回はyahooのサイトにPingが通るか確認した。

ping www.yahoo.co.jp

参考文献

VMware VMnet8(NAT)でネットワーク設定したのでメモ - あとらすの備忘録